La ausencia de regulaciones claras puede llevar a consecuencias no deseadas, como:

-

Discriminación algorítmica: Los sistemas de IA pueden perpetuar sesgos existentes si no se diseñan y entrenan adecuadamente.

-

Violaciones de privacidad: El uso indebido de datos personales puede comprometer la privacidad de los individuos.

-

Desinformación: La generación de contenido falso o manipulador puede ser facilitada por tecnologías de IA sin control.

-

Desplazamiento laboral: La automatización sin planificación puede afectar negativamente a ciertos sectores laborales.

Principios para una gobernanza ética de la IA

Para mitigar estos riesgos, expertos y organizaciones internacionales han propuesto principios clave:

-

Transparencia: Los algoritmos deben ser comprensibles y sus decisiones explicables.

-

Justicia: Evitar sesgos y garantizar que la IA beneficie a todos por igual.

-

Responsabilidad: Establecer mecanismos claros para rendir cuentas por las acciones de la IA.

-

Privacidad y seguridad: Proteger los datos personales y garantizar la seguridad de los sistemas de IA.

-

Sostenibilidad: Desarrollar IA que promueva el bienestar social y ambiental.

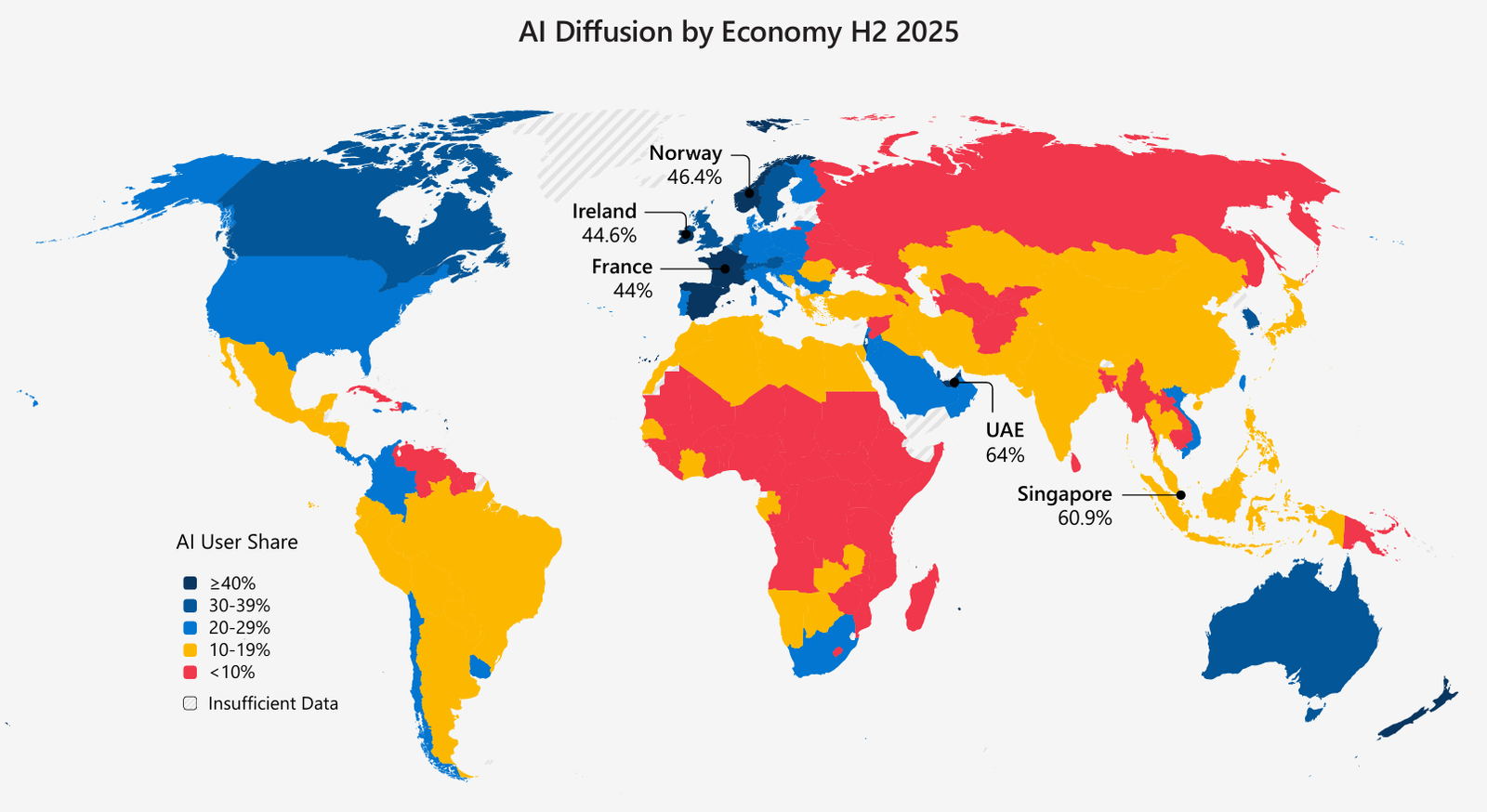

Iniciativas globales

Organismos internacionales, como las Naciones Unidas, están trabajando en marcos normativos para la IA. Estas iniciativas buscan establecer directrices que aseguren un desarrollo y uso responsable de la tecnología.

En resumen, la gobernanza de la IA no solo es una cuestión técnica, sino también ética y social. Es fundamental que gobiernos, empresas y sociedad civil colaboren para crear un entorno en el que la IA se utilice para el beneficio común, minimizando sus riesgos y maximizando sus oportunidades.